zblog建站后除了填充网站内容外,最重要的一件事件就是提交搜索引擎进行收录。任何一家搜索引擎蜘蛛爬行网站的第一件事,就是先爬行网站目录下的robots.txt文件。可以看出作为zblog的建站者,robots.txt文件的重要性。

一、什么是robots.txt文件呢?

通过robots.txt文件可以为自己网站做个声明,告诉来抓取的搜索引擎哪些内容是可以抓取的,哪些是你不希望被抓取收录的。

二、网站都需要设置robots.txt文件吗?

一般只有您的网站包含不希望被视频搜索引擎收录的内容时,才需要建立使用robots.txt文件。如果您希望搜索引擎收录网站上所有内容,可以不建立robots.txt文件。

正常情况下我们的网站都是需要建立robots.txt文件的。因为所有的网站都存在没有意义价值的抓取收录,比如管理员路径,一些工具文件路径等等。抓取收录都是没有意义的,也浪费了蜘蛛的抓取效率。所以这个时候就可以通过设置robots.txt文件达到蜘蛛效率的最大化。

三、zblog的robots文件怎么设置?

文件格式介绍

User-agent: 描述搜索引擎的名称

例如:User-agent:* 代表允许所有搜索引擎收录。如果只允许某个搜索引擎抓取,后面的*换成对应的搜索引擎名称就可以了。

Disallow: 代表不同意被访问一组URL

例如:Disallow: /zb_system/,这样就静止蜘蛛访问收录这个文件夹下的文件,zblog的管理员文件夹就是这个。

Sitemap: 地图文件

这个简单了,后面直接放自己网站蜘蛛地图路径就可以了。当然了这个在robots里也可以不写。写上更好一些,影响并不大。

zblog设置实例

这个是58侠客个人博客的robots文件内容

User-agent: * 代表同意所有搜索引擎抓取收录

Disallow: /zb_system/ 代表不同意抓取收录zb_system下的文件路径,这个是zblog里管理路径。

Disallow: /zb_users/plugin/ 代表不同意抓取收录plugin下的文件路径,这个是zblog里的工具插件路径。

Disallow: /*?* 代表不同意抓取收录本站的动态链接。

Sitemap: https://www.taoyuanxia.com/sitemaps.xml 代表这是网站地图的抓取路径。

# robots.txt for www.58xiake.com 2020.02.28 协议声明所属方。可以不写。

四、zblog的robots文件设置注意事项

Robots工具目前支持48k的文件内容检测,注意了robots.txt文件不要设置的过大,目录最长不超过250个字符为好。

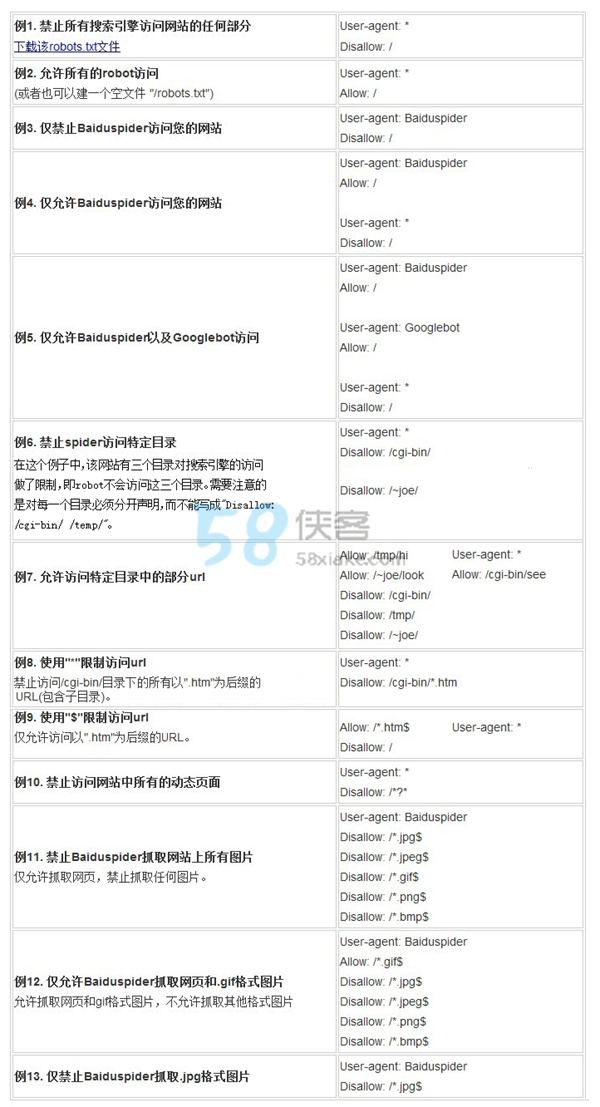

五、robots文件设置举例

六、错误设置了zblog的robots.txt文件怎么办?

解决方法

1.修改Robots封禁为允许,然后到百度站长后台检测并更新Robots。

在百度站长后台抓取检测,此时显示抓取失败,没关系,多点击抓取几次,触发蜘蛛抓取站点。

在百度站长后台抓取频次,申请抓取频次上调。

百度反馈中心,反馈是因为误操作导致了这种情况的发生。

百度站长后台链接提交处,设置数据主动推送(实时)。

更新sitemap网站地图,重新提交百度,每天手工提交一次。

以上处理完,接下来就是等待了,万幸,2天的时间数据开始慢慢回升,到第3天基本回升到正常状态!

还木有评论哦,快来抢沙发吧~